Llama3本地部署

看看官方介绍!

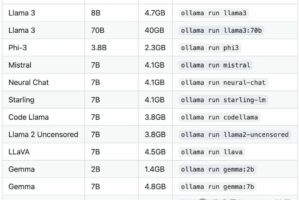

Llama3模型目前共开源了8B和70B两个参数规模的模型,400B参数规模的模型还在训练中。MetaAI也表示接下来的几个月里,将发布多个具有新功能的模型,包括多模态、多语言对话能力、更长的上下文窗口以及更强的综合能力的模型。

测试的方法和过程:

https://github.com/meta-llama/llama3/blob/main/eval_details.mdBlog: https://ai.meta.com/blog/meta-llama-3

HF: https://huggingface.co/meta-llama/Meta-Llama-3-70B

https://llama.meta.com/docs/model-cards-and-prompt-formats/meta-llama-3-

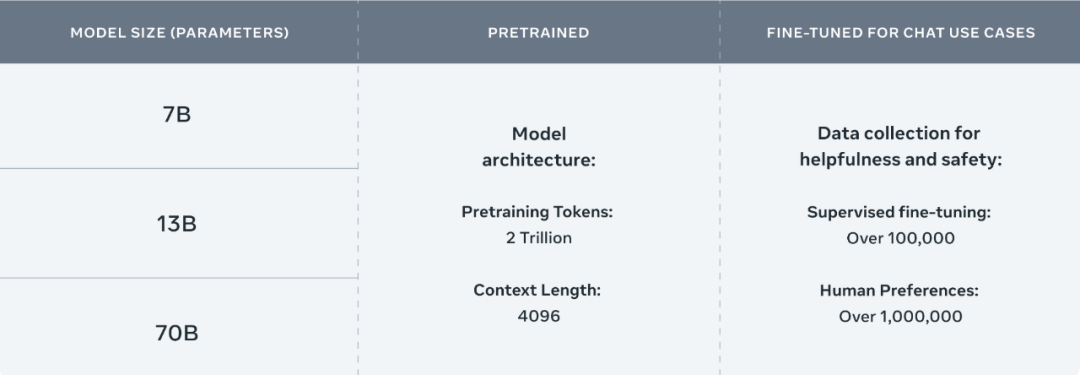

结构与Llama2基本一致,词表大小扩充到128K,8B和70B大小的模型中都采用了分组查询注意力(GQA),最大长度8K。 -

15T Tokens进行模型预训练,整体是Llama2的7倍,代码数据是Llama2的4倍,其中5%的数据由其他30种语言组成。 -

训练优化(数据并行、模型并行和流水线并行)实现同时在16K个GPU上训练,每个GPU的计算利用率超过400 TFLOPS。最终在24K个GPU上训练,相比于Llama2训练效率提高了约三倍。

微信赞赏

微信赞赏 支付宝扫码领红包

支付宝扫码领红包

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。侵权投诉:375170667@qq.com